Google Search Console is een krachtige tool waarmee je gedetailleerde inzichten krijgt in hoe Google jouw website crawlt en indexeert. Het biedt waardevolle informatie over hoe vaak Google jouw site bezoekt, welke pagina’s prioriteit krijgen, en waar mogelijke problemen zich voordoen. Dit is vooral belangrijk als je een grote website hebt, waar het crawlbudget een grote rol speelt in de vindbaarheid van je content.

Inzicht in het aantal crawlverzoeken

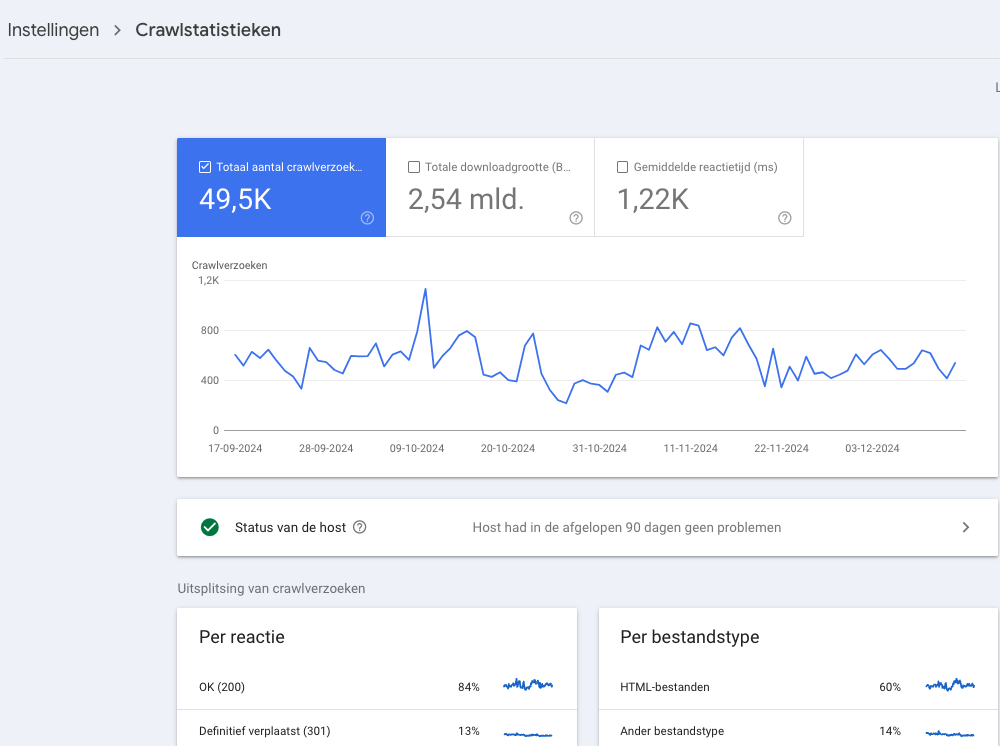

Onder het rapport “Instellingen > Crawlen > Statistieken voor crawlen kun je zien hoe Google jouw crawlbudget gebruikt. Je kunt trends volgen, zoals pieken of dalingen in het aantal crawlverzoeken, en problemen detecteren die mogelijk invloed hebben op de efficiëntie van het crawlen.

Crawlverzoeken analyseren

Het cijfer 49,5k toont het aantal keren dat Googlebot een verzoek heeft gedaan om pagina’s of bestanden op jouw site te crawlen in de afgelopen 90 dagen.

Een plotselinge daling kan duiden op technische problemen, zoals een fout in je robots.txt of trage servers. Pieken kunnen wijzen op nieuwe content die Google snel probeert te indexeren.

Het totale aantal crawlverzoeken geeft aan hoe actief Google jouw site crawlt. Veel crawlverzoeken betekenen meestal dat Google jouw site belangrijk vindt en regelmatig nieuwe of veranderde content controleert. Als je een grote site hebt met veel pagina’s, kan een hoog aantal normaal zijn.

Hoe kun je zien dat je crawlbudget wordt overschreden?

1. Lage crawlactiviteit: Als je veel meer pagina’s hebt dan het aantal crawlverzoeken dat Google doet, kan dit een indicatie zijn dat je crawlbudget niet optimaal wordt benut.

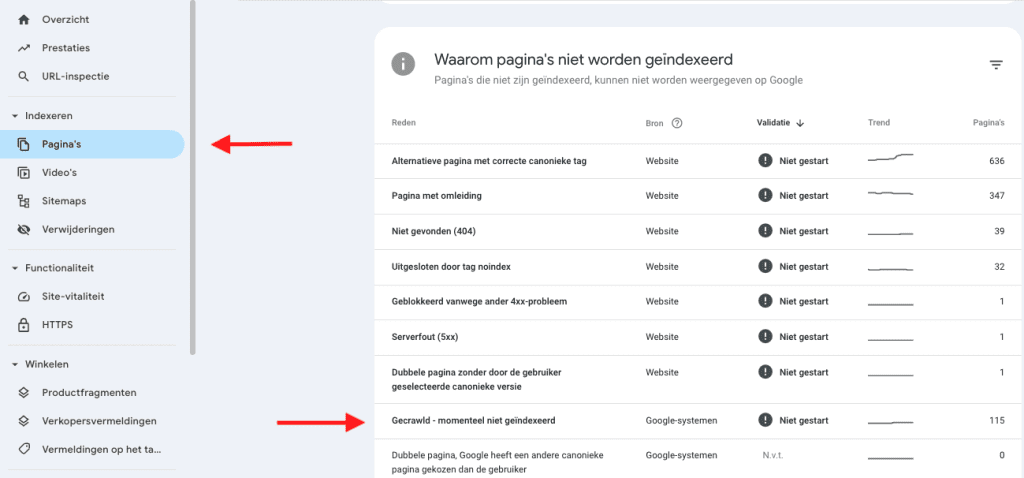

2. Niet-geïndexeerde pagina’s: Controleer in het indexatie rapport van Google Search Console of veel van je URL’s de status hebben “Gecrawled – momenteel niet geïndexeerd.” Dit kan betekenen dat Google jouw site niet volledig crawlt. Navigeer naar Indexeren> Pagina’s> Gecrawld – momenteel niet geïndexeerd.

Tip: Als er pagina’s staan die niet zijn uitgesloten in robots.txt maar toch niet zijn geïndexeerd, kan dit erop wijzen dat je crawlbudget is overschreden.

3. Serverproblemen: Kijk in het Crawlstatistiekenrapport of er veel serverfouten of een trage reactietijd zijn, wat een impact kan hebben op hoeveel pagina’s Google kan crawlen.

Hoe kun je ervoor zorgen dat je crawlbudget effectief wordt besteed?

Om je crawlbudget optimaal te benutten, is het belangrijk dat Googlebot zijn tijd en resources besteedt aan de meest waardevolle en relevante pagina’s van je website. Door efficiënte maatregelen te nemen, voorkom je dat irrelevante of minder belangrijke pagina’s onnodig worden gecrawld. Hier zijn een aantal stappen praktische stappen:

1. Gebruik een robots.txt-bestand om irrelevante pagina’s uit te sluiten

Een robots.txt-bestand is een krachtige tool om zoekmachines te sturen en te voorkomen dat ze onbelangrijke pagina’s crawlen. Dit helpt om je crawlbudget te richten op de content die er écht toe doet.

Wat uitsluiten?

- Dubbele content of pagina’s met weinig waarde.

- Filterpagina’s of zoekresultatenpagina’s van je website.

- Testpagina’s of staging-omgevingen.

2. Minimaliseer duplicatie en onnodige content

Dubbele pagina’s verspillen kostbare crawlresources en verminderen de prioriteit van belangrijke URL’s. Gebruik canonical tag of een noindex-meta tag om duplicatie te verminderen en Googlebot te sturen.

3. Optimaliseer je websitestructuur

Een duidelijke interne linkstructuur helpt Google snel de belangrijkste pagina’s te vinden.

- Zorg dat belangrijke pagina’s slechts enkele klikken van de homepage verwijderd zijn.

- Gebruik interne links om de waarde van je belangrijkste content te benadrukken

4. Creëer en update een XML-sitemap

Een XML-sitemap biedt Google een overzicht van je belangrijkste URL’s. Dit versnelt het crawlen van nieuwe of bijgewerkte content. Zorg ervoor dat de sitemap:

- Alleen relevante en waardevolle pagina’s bevat.

- Regelmatig wordt bijgewerkt en ingediend via Google Search Console

Conclusie

Het crawlbudget speelt een cruciale rol in de vindbaarheid van je website, vooral als je een grote site hebt met veel pagina’s. Door het rapport “Crawlstatistieken” in Google Search Console te analyseren, kun je zien hoe Google jouw website crawlt en waar verbeterpunten liggen. Controleer regelmatig op fouten zoals niet-geïndexeerde pagina’s, serverproblemen of inefficiënt gebruik van het crawlbudget.

Met praktische stappen zoals het uitsluiten van irrelevante pagina’s via een robots.txt-bestand, het optimaliseren van je websitestructuur en het bijwerken van je XML-sitemap, zorg je ervoor dat Google zijn tijd besteedt aan de belangrijkste pagina’s. Dit leidt tot betere indexering, verbeterde zichtbaarheid in zoekresultaten en een gezondere website.

Vond je dit interessant? Houd dan onze kennisbank in de gaten.